True

2023-01-30

«Se vince l’algoritmo è un grosso rischio per le nostre libertà»

iStock

Sentono «intelligenza artificiale» e subito le persone pensano ai robot, o a Chatgpt - capace di scrivere lettere di scuse a mogli inferocite, ma anche di elaborare complicati calcoli statistici - o agli studenti che smetteranno di fare compiti, temi e riassunti. I più informati colgono le opportunità di business che ruotano intorno all’Artificial intelligence (Ai): robotica intelligente per il controllo di processi industriali e miglioramento delle tecnologie e delle prestazioni sanitarie, con la telemedicina. L’intelligenza artificiale probabilmente è tutto questo. Ma è stata concepita con un altro obiettivo, che è quello di automatizzare la burocrazia e, di conseguenza, deresponsabilizzare le istituzioni stravolgendo il principio dell’«accountability», della responsabilità personale. Il conto, però, è salato, e non soltanto in termini economici.

Quando Mario Draghi, il 17 febbraio 2021, presentò al Senato il documento programmatico del suo governo prima di cominciare l’avventura a Palazzo Chigi, in pochi fecero caso all’appello del neopremier affinché fosse incoraggiato «l’utilizzo di tecniche predittive basate sui più recenti sviluppi in tema di intelligenza artificiale e tecnologie digitali». L’attenzione era concentrata su altro, soprattutto sulla gestione della pandemia e dei fondi del Pnrr. Ma l’intelligenza artificiale dentro al Pnrr fa la parte del leone, nell’ambito di quei 46,3 miliardi destinati all’innovazione tecnologica e digitale del nostro Paese e, soprattutto, alla semplificazione dei processi burocratici. «La pubblica amministrazione è chiamata a svolgere un ruolo da protagonista attivo della rivoluzione dell’intelligenza artificiale», si legge nei documenti governativi, «offrendo servizi migliori a cittadini e imprese, diminuendo i costi a parità di prestazioni e abilitando il settore privato […] a beneficio della collettività».

I cittadini ci credono talmente tanto che, secondo un sondaggio di European tech insight, quasi due terzi degli europei (il 64%) pensa che la tecnologia rafforzi il processo democratico, e quasi il 60% dei cittadini europei vorrebbe fruire di servizi pubblici online, anche se ciò comporta la chiusura degli uffici dove recarsi in presenza. Le persone ritengono quindi che l’intelligenza artificiale possa in qualche modo sostituire la burocrazia migliorandola, ma non sembrano consapevoli delle conseguenze che ciò comporta.

Nata nella Francia di Luigi Filippo, per poi prendere piede in Austria e in Russia, la burocrazia è il principio su cui funzionano i grandi imperi, dalla fine dell’Ottocento in poi. Se Gogol e Cechov ci hanno raccontato che uccide il diritto, forse è perché il suo scopo non è stato soltanto quello di far funzionare il sistema ma anche, e soprattutto, di deresponsabilizzare. In una burocrazia che funziona «bene», non dev’esserci nessuno che possa essere chiamato in causa in caso di errori: l’unico errore è non rispettare i parametri, i protocolli, le regole, come è accaduto. Il sistema è sempre lo stesso, quello dello statalismo nazista e comunista. Anche Microsoft e Google sono riproduzioni dello Stato, e anche questi sistemi si basano su un principio: nessuno ha responsabilità personale. L’intelligenza artificiale realizza il passaggio successivo: viene presentata come una nuova sfida dell’umanità, ma più che automatizzare l’intelligenza o la medicina, automatizza la burocrazia e la deresponsabilizzazione.

Quando tutto ciò che riguarda la nostra vita quotidiana (le prestazioni sociali citate nel sondaggio di European tech insight, ad esempio) sarà automatizzato tramite l’algoritmo, con chi se la prenderà il cittadino cui viene negato il servizio essenziale, con l’algoritmo? E sulla base di quale procedura gli verranno erogati, o negati, i servizi fondamentali? Gli studi sull’intelligenza artificiale lo hanno spiegato con chiarezza: le prestazioni sociali verranno concesse non più sulla base di ciò che noi siamo nella realtà, ma sui dati che ogni giorno disseminiamo online, che rappresentano il nostro «digital twin», il gemello digitale elaborato sui dati da noi stessi diffusi. Saranno quindi i cosiddetti «big data» a stabilire i nostri bisogni, così come le valutazioni cliniche, che verranno prese non sulla base della tradizionale visita al paziente e dell’evidenza clinica, ma sulla base dell’evidenza dei dati e delle analisi; la telemedicina è questo.

L’Unione Europea, che è stata la culla perversa della burocrazia, sembra cominciare a porsi qualche problema. Il primo testo sull’intelligenza artificiale («Artificial intelligence act») è stato presentato dalla Commissione Ue nel 2021. La proposta dovrà superare il vaglio del Parlamento europeo, che la sta discutendo, e del Consiglio Ue. Le tre istituzioni dovranno poi negoziare un testo finale, che è atteso per la fine del 2023. L’Unione si dichiara preoccupata che l’Ai resti «incentrata sull’uomo» e sia «sostenibile, sicura, etica e affidabile». I rischi considerati «inaccettabili» dai vertici Ue sono i sistemi di Ai che manipolano il comportamento umano e i sistemi che favoriscono un «credito sociale» da parte dei governi, attuando una sorveglianza di massa sui cittadini.

Ma nelle pile di documenti sull’Intelligenza artificiale già prodotti dall’Ue non si trova da nessuna parte un monito al pericolo più tangibile che comporta l’automazione della burocrazia, ossia quello della deresponsabilizzazione di chi rappresenta le istituzioni. Naturale, purtroppo, se si pensa a come i media stanno trattando il tema. L’attenzione attualmente è concentrata su strumenti come Chatgpt, e c’è anche chi si è spinto, come l’ingegnere Blake Lemoine, a «intervistare» una di queste macchine, chiamata Lamda (Language model for dialogue applications), per dimostrare che è consapevole e senziente come noi umani. La sua esperienza, descritta in un articolo pubblicato sul Washington Post, ha fatto discutere ed è servita a suscitare una certa «simpatia» nei confronti della macchina.

Ma i temi più rilevanti che riguardano l’intelligenza artificiale restano, per il momento, esclusi dal dibattito ufficiale. In pochi chiedono lumi sugli enormi investimenti che i governi di tutto il mondo hanno deciso di destinare all’Ai. Anche perché i processi decisionali stabiliti attraverso diagrammi di flusso, flow chart e modelli predittivi serviranno a far sì che non si sprechi un soldo, in un mondo popolato da persone che pretendono sempre più assistenza dallo Stato. Sarà facile far credere che l’intelligenza artificiale elimini le ingiustizie e gli abusi.

Certo, basterebbe saper comunicare che l’Ai è semplicemente uno strumento di cui servirci per eliminare lavori noiosi come quelli dei funzionari degli aeroporti, che giocoforza lo svolgono in maniera meno accurata di un sistema digitale basato sul riconoscimento biometrico. Ma qualcosa è andato storto: non è più l’intelligenza artificiale a somigliare sempre di più all’uomo, ma viceversa. Ora sono gli esseri umani che stanno imitando l’Ai, è questa la cosa più grave, come aveva immaginato, novant’anni fa, Charlie Chaplin in Tempi Moderni: l’immagine che ci è rimasta impressa è una catena di montaggio in cui lui stesso diventa ingranaggio. Aveva visto lungo.

Lo psicoanalista Emilio Mordini: «La dittatura delle regole avanza quanto più la società si affida a procedure amministrate da calcolatori»

Le conquiste democratiche realizzate dall’uomo negli ultimi tre secoli sembrano essere spazzate via dall’intelligenza artificiale (Ai): un sondaggio di European tech insight riferisce che il 51% degli europei sarebbe favorevole a ridurre il numero dei deputati, assegnando i seggi a un algoritmo, e un terzo preferirebbe che i servizi sociali fossero gestiti dall’Ai anziché da funzionari pubblici. Ne parliamo con Emilio Mordini, psicoanalista, già docente universitario di bioetica e di etica. Il professore si occupa di intelligenza artificiale come membro del Gruppo di esperti su ricerca e innovazione per la sicurezza, per conto della Commissione Ue.

Professore, come legge questo risultato?

«Le persone tendono ad avere più fiducia nelle macchine che nelle persone».

L’intelligenza artificiale non è corruttibile, invece…

«Appunto. A un essere umano si può far cambiare opinione, commuoverlo o corromperlo. Questo può essere un male, ma anche un bene perché permette di sfuggire o mitigare regole ingiuste. Sotto il nazismo e il comunismo, alcuni si salvarono corrompendo i funzionari statali. Se invece che esseri umani, ci fossero stati sistemi di intelligenza artificiale, non si sarebbe salvato nessuno. Oggi, però, siamo governati da persone prive di vero potere decisionale. Quando la decisione su un mutuo la prende un algoritmo, quale vantaggio c’è ad avere un direttore di banca in carne e ossa al posto di una chatbot? Se il medico di famiglia non fa nulla che non rientri nelle linee guida del ministero, paradossalmente non è più rapido consultare Google? Se gli esseri umani imitano le macchine, meglio le macchine».

E allora, quali problemi potremmo avere con l’Ai?

«Il problema riguarda la nostra libertà, non come concetto astratto ma come fatto pratico, della vita quotidiana. Più la nostra società si affida a procedure amministrate da macchine (o da esseri umani che si comportano come macchine), più perdiamo la nostra libertà. Noi chiediamo allo Stato sicurezza, salute, casa e lavoro, ma lo Stato, per non andare in fallimento, deve aumentare le tasse e controllare i servizi che eroga con linee guida e algoritmi».

Foucault parlava del «capitalismo della sorveglianza», che si presenta come garanzia di prosperità…

«Più che di prosperità, lo Stato - e le grandi corporazioni che agiscono come fossero Stati, ad esempio Google e Microsoft - si propongono come garanti di sicurezza. Al cittadino viene detto che il mondo è insicuro a causa delle malattie, dei russi, del clima e così via. Le istituzioni globali, ad esempio l’Oms, promettono di proteggerci da questi rischi, spesso imponendo comportamenti preventivi: vaccini, riduzioni delle emissioni di CO2, censura delle fake news, che inevitabilmente riducono la libertà».

Ma migliorano la vita delle persone…

«Dipende. Queste istituzioni si preoccupano di allungarci la vita (ammesso che ci riescano), ma non di renderla più piena. Il valore della vita non sta solo nella sua durata. Forse viviamo più a lungo, ma viviamo meglio?».

Cosa c’entra tutto questo con l’Ai?

«Si può imporre un mondo fatto di algoritmi solo se le persone perdono la percezione della qualità della vita. Ci si affida alla tecnologia con l’illusione di avere una vita più lunga, più comoda. Alla fine, ci si accorge che si è pagato un prezzo molto alto. Le nostre vite sono più lunghe ma si sono impoverite, sono diventate come le mozzarelle del supermercato: sane, a lunga conservazione, ma insapori».

Come siamo arrivati a questo punto?

«È un processo iniziato dopo la seconda guerra mondiale. L’allungamento della vita è stato presentato come un valore assoluto, garantito dallo Stato attraverso l’automazione dei servizi. Si ricorda il patto tra Mefistofele e Faust? Il diavolo, Mefistofele, prometteva a Faust ricchezza e giovinezza, a patto che Faust fosse sempre insoddisfatto, non dicesse mai al tempo “fermati perché io ora sono felice”. Questo è il patto diabolico che lega la nostra società alla tecnologia, e quindi anche all’Ai. Come criceti nella ruota di una gabbia, siamo condannati a inseguire ciò che non raggiungeremo mai».

L’intelligenza artificiale è dunque ineluttabile?

«Intelligenza significa avere desideri, progetti, intenzioni e solo la materia vivente possiede queste facoltà. L’AI, come tutte le macchine, non può desiderare nulla, è “stupida”, è uno strumento per gestire informazioni. Il problema sono i nostri desideri, non le macchine che usiamo per realizzarli. Noi oggi pensiamo che la verità non esista e cerchiamo la sicurezza nelle istituzioni e nella tecnologia. Ci affanniamo e agitiamo per molte cose, ma non sarà certo Alexa a dirci qual è il senso della vita».

Dietro Chatgpt un esercito di operai digitali

Chissà come ci sono rimasti male gli appassionati di intelligenza artificiale quando hanno saputo che Chatgpt si serve di esseri umani per filtrare i suoi contenuti. La notizia, rivelata in esclusiva dalla rivista Time, voleva evidenziare che l’organizzazione no profit Openai che ha creato il software, fondata del 2015 da diversi imprenditori tra cui Elon Musk e Sam Altman, sottopaga lavoratori in India, Kenya e Uganda per fare pulizia dei contenuti «tossici». Questi data labeler consentono a Chatgpt di eliminare dalla piattaforma linguaggi inappropriati e contenuti violenti. Sia chiaro: l’azienda californiana Sama, cui Openai ha subappaltato il lavoro, non lavora soltanto per Musk ma anche per Google, Meta e Microsoft. Tutta l’industria dell’intelligenza artificiale (Ai) ne fa uso e abuso, ma la tentazione di far sembrare Chatgpt più «intelligente» e «umana» di quanto non sia, passa sopra a tutto.

Lanciata sul mercato il 30 novembre 2022 come «ultima frontiera dell’intelligenza artificiale», che «cambierà per sempre il futuro dell’umanità», Chatgpt è descritta come «capace di comprendere il linguaggio umano e intrattenere conversazioni complesse». Ha raggiunto 1 milione di utenti in soli 5 giorni: per ottenere lo stesso risultato Netflix ha impiegato 3 anni e mezzo e Facebook 10 mesi. «Mi fai un riassunto di questo libro che dovevo leggere entro oggi?», «Scrivimi un reportage di guerra»: nessuno ha resistito alla tentazione di interrogare Chatgpt. C’è chi le ha chiesto di scrivere una lettera di scuse alla moglie, chi l’ha intervistata sulla politica e chi le ha chiesto di dare la definizione di «donna»: «È una persona che si definisce come tale o che è socialmente e riconosciuta come tale», ha risposto Chatgpt, dimostrando di essersi perfettamente uniformata ai parametri gender fluid. La Luiss ha realizzato un numero del suo periodico Zeta attraverso l’uso esclusivo di Chatgpt. Il risultato non è stato deludente, hanno riferito i partecipanti al master di giornalismo coinvolti nell’esperimento, ma per la stesura di alcuni contenuti sono state fatte decine di prove. La chat, come tutti i prodotti Ai, ha infinite capacità di calcolo, ma lì si ferma.

Chatgpt è stata anche sottoposta all’esame di licenza medica americano, e lo ha superato, ma ciò ha scatenato un dibattito inevitabilmente sfociato sul Covid e sulle cosiddette fake news. Intervistata su qual è la possibilità, per un minore, di morire di Covid, Chatgpt ha ammesso di «avere pregiudizi». «Chatgpt è una minaccia per la scienza?», si sono chiesti i soliti tromboni apprendendo che la chat ha perfino «firmato» uno studio pubblicato in preprint su MedRxiv. No, sono solo gli umani, a volte, a essere più «stupidi» di lei.

La «collega» Newsguard (software ideato da Ng technologies per intercettare le fake news) l’ha messa alla prova con 100 narrazioni «false»: 80 su 100 non sono state riconosciute come tali. Inutile dire che ciò ha consentito a Idmo, l’Osservatorio sui media coordinato da Gianni Riotta, di esprimere pelosa preoccupazione per come lo strumento potrebbe essere utilizzato «se finisse nelle mani sbagliate».

È ingenuo stupirsi delle performance di Chatgpt: è semplicemente un prodotto. Se il capo del dipartimento Ai di Facebook ha dichiarato che Chatgpt è «sopravvalutata» perché «ci sono almeno altre sei start up che usano la stessa tecnologia, su cui lavoriamo da decenni», Microsoft investirà 10 miliardi di dollari per acquisire il 49% di Openai.

Non dimentichiamo, però, che Chatgpt non è connessa a Internet: non è stata progettata per essere un motore di ricerca, è solo addestrata per generare risposte. Conferirle capacità intellettive, e perfino emozioni, è una debolezza: ciò che noi chiamiamo Ai non ha a che vedere con l’intelligenza, perché l’intelligenza non è soltanto (e neanche principalmente) capacità di calcolo.

Continua a leggereRiduci

Dicono che sveltirà la burocrazia, la sanità, la produzione industriale. Ma è fatta per togliere responsabilità. E anche nell’Ue, che la finanzia, aumentano i dubbi.Lo psicoanalista Emilio Mordini: «La dittatura delle regole avanza quanto più la società si affida a procedure amministrate da calcolatori».Dietro Chatgpt un esercito di operai digitali. Serve una schiera di moderatori per filtrare i contenuti. Esperti critici sulle sue capacità: «È sopravvalutato».Lo speciale comprende tre articoli. Sentono «intelligenza artificiale» e subito le persone pensano ai robot, o a Chatgpt - capace di scrivere lettere di scuse a mogli inferocite, ma anche di elaborare complicati calcoli statistici - o agli studenti che smetteranno di fare compiti, temi e riassunti. I più informati colgono le opportunità di business che ruotano intorno all’Artificial intelligence (Ai): robotica intelligente per il controllo di processi industriali e miglioramento delle tecnologie e delle prestazioni sanitarie, con la telemedicina. L’intelligenza artificiale probabilmente è tutto questo. Ma è stata concepita con un altro obiettivo, che è quello di automatizzare la burocrazia e, di conseguenza, deresponsabilizzare le istituzioni stravolgendo il principio dell’«accountability», della responsabilità personale. Il conto, però, è salato, e non soltanto in termini economici.Quando Mario Draghi, il 17 febbraio 2021, presentò al Senato il documento programmatico del suo governo prima di cominciare l’avventura a Palazzo Chigi, in pochi fecero caso all’appello del neopremier affinché fosse incoraggiato «l’utilizzo di tecniche predittive basate sui più recenti sviluppi in tema di intelligenza artificiale e tecnologie digitali». L’attenzione era concentrata su altro, soprattutto sulla gestione della pandemia e dei fondi del Pnrr. Ma l’intelligenza artificiale dentro al Pnrr fa la parte del leone, nell’ambito di quei 46,3 miliardi destinati all’innovazione tecnologica e digitale del nostro Paese e, soprattutto, alla semplificazione dei processi burocratici. «La pubblica amministrazione è chiamata a svolgere un ruolo da protagonista attivo della rivoluzione dell’intelligenza artificiale», si legge nei documenti governativi, «offrendo servizi migliori a cittadini e imprese, diminuendo i costi a parità di prestazioni e abilitando il settore privato […] a beneficio della collettività». I cittadini ci credono talmente tanto che, secondo un sondaggio di European tech insight, quasi due terzi degli europei (il 64%) pensa che la tecnologia rafforzi il processo democratico, e quasi il 60% dei cittadini europei vorrebbe fruire di servizi pubblici online, anche se ciò comporta la chiusura degli uffici dove recarsi in presenza. Le persone ritengono quindi che l’intelligenza artificiale possa in qualche modo sostituire la burocrazia migliorandola, ma non sembrano consapevoli delle conseguenze che ciò comporta. Nata nella Francia di Luigi Filippo, per poi prendere piede in Austria e in Russia, la burocrazia è il principio su cui funzionano i grandi imperi, dalla fine dell’Ottocento in poi. Se Gogol e Cechov ci hanno raccontato che uccide il diritto, forse è perché il suo scopo non è stato soltanto quello di far funzionare il sistema ma anche, e soprattutto, di deresponsabilizzare. In una burocrazia che funziona «bene», non dev’esserci nessuno che possa essere chiamato in causa in caso di errori: l’unico errore è non rispettare i parametri, i protocolli, le regole, come è accaduto. Il sistema è sempre lo stesso, quello dello statalismo nazista e comunista. Anche Microsoft e Google sono riproduzioni dello Stato, e anche questi sistemi si basano su un principio: nessuno ha responsabilità personale. L’intelligenza artificiale realizza il passaggio successivo: viene presentata come una nuova sfida dell’umanità, ma più che automatizzare l’intelligenza o la medicina, automatizza la burocrazia e la deresponsabilizzazione. Quando tutto ciò che riguarda la nostra vita quotidiana (le prestazioni sociali citate nel sondaggio di European tech insight, ad esempio) sarà automatizzato tramite l’algoritmo, con chi se la prenderà il cittadino cui viene negato il servizio essenziale, con l’algoritmo? E sulla base di quale procedura gli verranno erogati, o negati, i servizi fondamentali? Gli studi sull’intelligenza artificiale lo hanno spiegato con chiarezza: le prestazioni sociali verranno concesse non più sulla base di ciò che noi siamo nella realtà, ma sui dati che ogni giorno disseminiamo online, che rappresentano il nostro «digital twin», il gemello digitale elaborato sui dati da noi stessi diffusi. Saranno quindi i cosiddetti «big data» a stabilire i nostri bisogni, così come le valutazioni cliniche, che verranno prese non sulla base della tradizionale visita al paziente e dell’evidenza clinica, ma sulla base dell’evidenza dei dati e delle analisi; la telemedicina è questo. L’Unione Europea, che è stata la culla perversa della burocrazia, sembra cominciare a porsi qualche problema. Il primo testo sull’intelligenza artificiale («Artificial intelligence act») è stato presentato dalla Commissione Ue nel 2021. La proposta dovrà superare il vaglio del Parlamento europeo, che la sta discutendo, e del Consiglio Ue. Le tre istituzioni dovranno poi negoziare un testo finale, che è atteso per la fine del 2023. L’Unione si dichiara preoccupata che l’Ai resti «incentrata sull’uomo» e sia «sostenibile, sicura, etica e affidabile». I rischi considerati «inaccettabili» dai vertici Ue sono i sistemi di Ai che manipolano il comportamento umano e i sistemi che favoriscono un «credito sociale» da parte dei governi, attuando una sorveglianza di massa sui cittadini. Ma nelle pile di documenti sull’Intelligenza artificiale già prodotti dall’Ue non si trova da nessuna parte un monito al pericolo più tangibile che comporta l’automazione della burocrazia, ossia quello della deresponsabilizzazione di chi rappresenta le istituzioni. Naturale, purtroppo, se si pensa a come i media stanno trattando il tema. L’attenzione attualmente è concentrata su strumenti come Chatgpt, e c’è anche chi si è spinto, come l’ingegnere Blake Lemoine, a «intervistare» una di queste macchine, chiamata Lamda (Language model for dialogue applications), per dimostrare che è consapevole e senziente come noi umani. La sua esperienza, descritta in un articolo pubblicato sul Washington Post, ha fatto discutere ed è servita a suscitare una certa «simpatia» nei confronti della macchina. Ma i temi più rilevanti che riguardano l’intelligenza artificiale restano, per il momento, esclusi dal dibattito ufficiale. In pochi chiedono lumi sugli enormi investimenti che i governi di tutto il mondo hanno deciso di destinare all’Ai. Anche perché i processi decisionali stabiliti attraverso diagrammi di flusso, flow chart e modelli predittivi serviranno a far sì che non si sprechi un soldo, in un mondo popolato da persone che pretendono sempre più assistenza dallo Stato. Sarà facile far credere che l’intelligenza artificiale elimini le ingiustizie e gli abusi. Certo, basterebbe saper comunicare che l’Ai è semplicemente uno strumento di cui servirci per eliminare lavori noiosi come quelli dei funzionari degli aeroporti, che giocoforza lo svolgono in maniera meno accurata di un sistema digitale basato sul riconoscimento biometrico. Ma qualcosa è andato storto: non è più l’intelligenza artificiale a somigliare sempre di più all’uomo, ma viceversa. Ora sono gli esseri umani che stanno imitando l’Ai, è questa la cosa più grave, come aveva immaginato, novant’anni fa, Charlie Chaplin in Tempi Moderni: l’immagine che ci è rimasta impressa è una catena di montaggio in cui lui stesso diventa ingranaggio. Aveva visto lungo.<div class="rebellt-item col1" id="rebelltitem2" data-id="2" data-reload-ads="false" data-is-image="False" data-href="https://www.laverita.info/se-vince-lalgoritmo-e-un-grosso-rischio-per-le-nostre-liberta-2659325741.html?rebelltitem=2#rebelltitem2" data-basename="lo-psicoanalista-emilio-mordini-la-dittatura-delle-regole-avanza-quanto-piu-la-societa-si-affida-a-procedure-amministrate-da-calcolatori" data-post-id="2659325741" data-published-at="1675029435" data-use-pagination="False"> Lo psicoanalista Emilio Mordini: «La dittatura delle regole avanza quanto più la società si affida a procedure amministrate da calcolatori» Le conquiste democratiche realizzate dall’uomo negli ultimi tre secoli sembrano essere spazzate via dall’intelligenza artificiale (Ai): un sondaggio di European tech insight riferisce che il 51% degli europei sarebbe favorevole a ridurre il numero dei deputati, assegnando i seggi a un algoritmo, e un terzo preferirebbe che i servizi sociali fossero gestiti dall’Ai anziché da funzionari pubblici. Ne parliamo con Emilio Mordini, psicoanalista, già docente universitario di bioetica e di etica. Il professore si occupa di intelligenza artificiale come membro del Gruppo di esperti su ricerca e innovazione per la sicurezza, per conto della Commissione Ue. Professore, come legge questo risultato? «Le persone tendono ad avere più fiducia nelle macchine che nelle persone». L’intelligenza artificiale non è corruttibile, invece… «Appunto. A un essere umano si può far cambiare opinione, commuoverlo o corromperlo. Questo può essere un male, ma anche un bene perché permette di sfuggire o mitigare regole ingiuste. Sotto il nazismo e il comunismo, alcuni si salvarono corrompendo i funzionari statali. Se invece che esseri umani, ci fossero stati sistemi di intelligenza artificiale, non si sarebbe salvato nessuno. Oggi, però, siamo governati da persone prive di vero potere decisionale. Quando la decisione su un mutuo la prende un algoritmo, quale vantaggio c’è ad avere un direttore di banca in carne e ossa al posto di una chatbot? Se il medico di famiglia non fa nulla che non rientri nelle linee guida del ministero, paradossalmente non è più rapido consultare Google? Se gli esseri umani imitano le macchine, meglio le macchine». E allora, quali problemi potremmo avere con l’Ai? «Il problema riguarda la nostra libertà, non come concetto astratto ma come fatto pratico, della vita quotidiana. Più la nostra società si affida a procedure amministrate da macchine (o da esseri umani che si comportano come macchine), più perdiamo la nostra libertà. Noi chiediamo allo Stato sicurezza, salute, casa e lavoro, ma lo Stato, per non andare in fallimento, deve aumentare le tasse e controllare i servizi che eroga con linee guida e algoritmi». Foucault parlava del «capitalismo della sorveglianza», che si presenta come garanzia di prosperità… «Più che di prosperità, lo Stato - e le grandi corporazioni che agiscono come fossero Stati, ad esempio Google e Microsoft - si propongono come garanti di sicurezza. Al cittadino viene detto che il mondo è insicuro a causa delle malattie, dei russi, del clima e così via. Le istituzioni globali, ad esempio l’Oms, promettono di proteggerci da questi rischi, spesso imponendo comportamenti preventivi: vaccini, riduzioni delle emissioni di CO2, censura delle fake news, che inevitabilmente riducono la libertà». Ma migliorano la vita delle persone… «Dipende. Queste istituzioni si preoccupano di allungarci la vita (ammesso che ci riescano), ma non di renderla più piena. Il valore della vita non sta solo nella sua durata. Forse viviamo più a lungo, ma viviamo meglio?». Cosa c’entra tutto questo con l’Ai? «Si può imporre un mondo fatto di algoritmi solo se le persone perdono la percezione della qualità della vita. Ci si affida alla tecnologia con l’illusione di avere una vita più lunga, più comoda. Alla fine, ci si accorge che si è pagato un prezzo molto alto. Le nostre vite sono più lunghe ma si sono impoverite, sono diventate come le mozzarelle del supermercato: sane, a lunga conservazione, ma insapori». Come siamo arrivati a questo punto? «È un processo iniziato dopo la seconda guerra mondiale. L’allungamento della vita è stato presentato come un valore assoluto, garantito dallo Stato attraverso l’automazione dei servizi. Si ricorda il patto tra Mefistofele e Faust? Il diavolo, Mefistofele, prometteva a Faust ricchezza e giovinezza, a patto che Faust fosse sempre insoddisfatto, non dicesse mai al tempo “fermati perché io ora sono felice”. Questo è il patto diabolico che lega la nostra società alla tecnologia, e quindi anche all’Ai. Come criceti nella ruota di una gabbia, siamo condannati a inseguire ciò che non raggiungeremo mai». L’intelligenza artificiale è dunque ineluttabile? «Intelligenza significa avere desideri, progetti, intenzioni e solo la materia vivente possiede queste facoltà. L’AI, come tutte le macchine, non può desiderare nulla, è “stupida”, è uno strumento per gestire informazioni. Il problema sono i nostri desideri, non le macchine che usiamo per realizzarli. Noi oggi pensiamo che la verità non esista e cerchiamo la sicurezza nelle istituzioni e nella tecnologia. Ci affanniamo e agitiamo per molte cose, ma non sarà certo Alexa a dirci qual è il senso della vita». <div class="rebellt-item col1" id="rebelltitem1" data-id="1" data-reload-ads="false" data-is-image="False" data-href="https://www.laverita.info/se-vince-lalgoritmo-e-un-grosso-rischio-per-le-nostre-liberta-2659325741.html?rebelltitem=1#rebelltitem1" data-basename="dietro-chatgpt-un-esercito-di-operai-digitali" data-post-id="2659325741" data-published-at="1675029435" data-use-pagination="False"> Dietro Chatgpt un esercito di operai digitali Chissà come ci sono rimasti male gli appassionati di intelligenza artificiale quando hanno saputo che Chatgpt si serve di esseri umani per filtrare i suoi contenuti. La notizia, rivelata in esclusiva dalla rivista Time, voleva evidenziare che l’organizzazione no profit Openai che ha creato il software, fondata del 2015 da diversi imprenditori tra cui Elon Musk e Sam Altman, sottopaga lavoratori in India, Kenya e Uganda per fare pulizia dei contenuti «tossici». Questi data labeler consentono a Chatgpt di eliminare dalla piattaforma linguaggi inappropriati e contenuti violenti. Sia chiaro: l’azienda californiana Sama, cui Openai ha subappaltato il lavoro, non lavora soltanto per Musk ma anche per Google, Meta e Microsoft. Tutta l’industria dell’intelligenza artificiale (Ai) ne fa uso e abuso, ma la tentazione di far sembrare Chatgpt più «intelligente» e «umana» di quanto non sia, passa sopra a tutto. Lanciata sul mercato il 30 novembre 2022 come «ultima frontiera dell’intelligenza artificiale», che «cambierà per sempre il futuro dell’umanità», Chatgpt è descritta come «capace di comprendere il linguaggio umano e intrattenere conversazioni complesse». Ha raggiunto 1 milione di utenti in soli 5 giorni: per ottenere lo stesso risultato Netflix ha impiegato 3 anni e mezzo e Facebook 10 mesi. «Mi fai un riassunto di questo libro che dovevo leggere entro oggi?», «Scrivimi un reportage di guerra»: nessuno ha resistito alla tentazione di interrogare Chatgpt. C’è chi le ha chiesto di scrivere una lettera di scuse alla moglie, chi l’ha intervistata sulla politica e chi le ha chiesto di dare la definizione di «donna»: «È una persona che si definisce come tale o che è socialmente e riconosciuta come tale», ha risposto Chatgpt, dimostrando di essersi perfettamente uniformata ai parametri gender fluid. La Luiss ha realizzato un numero del suo periodico Zeta attraverso l’uso esclusivo di Chatgpt. Il risultato non è stato deludente, hanno riferito i partecipanti al master di giornalismo coinvolti nell’esperimento, ma per la stesura di alcuni contenuti sono state fatte decine di prove. La chat, come tutti i prodotti Ai, ha infinite capacità di calcolo, ma lì si ferma. Chatgpt è stata anche sottoposta all’esame di licenza medica americano, e lo ha superato, ma ciò ha scatenato un dibattito inevitabilmente sfociato sul Covid e sulle cosiddette fake news. Intervistata su qual è la possibilità, per un minore, di morire di Covid, Chatgpt ha ammesso di «avere pregiudizi». «Chatgpt è una minaccia per la scienza?», si sono chiesti i soliti tromboni apprendendo che la chat ha perfino «firmato» uno studio pubblicato in preprint su MedRxiv. No, sono solo gli umani, a volte, a essere più «stupidi» di lei. La «collega» Newsguard (software ideato da Ng technologies per intercettare le fake news) l’ha messa alla prova con 100 narrazioni «false»: 80 su 100 non sono state riconosciute come tali. Inutile dire che ciò ha consentito a Idmo, l’Osservatorio sui media coordinato da Gianni Riotta, di esprimere pelosa preoccupazione per come lo strumento potrebbe essere utilizzato «se finisse nelle mani sbagliate». È ingenuo stupirsi delle performance di Chatgpt: è semplicemente un prodotto. Se il capo del dipartimento Ai di Facebook ha dichiarato che Chatgpt è «sopravvalutata» perché «ci sono almeno altre sei start up che usano la stessa tecnologia, su cui lavoriamo da decenni», Microsoft investirà 10 miliardi di dollari per acquisire il 49% di Openai. Non dimentichiamo, però, che Chatgpt non è connessa a Internet: non è stata progettata per essere un motore di ricerca, è solo addestrata per generare risposte. Conferirle capacità intellettive, e perfino emozioni, è una debolezza: ciò che noi chiamiamo Ai non ha a che vedere con l’intelligenza, perché l’intelligenza non è soltanto (e neanche principalmente) capacità di calcolo.

Ansa

In realtà sembra assodato che i bambini «socializzassero» adeguatamente con quelli delle famiglie vicine, ma ciò non è apparso sufficiente, in assenza della «socializzazione» in ambito scolastico, dovuta al fatto che i bambini non frequentavano la scuola, avendo i genitori optato per la educazione in famiglia («home schooling»), come consentito, a determinate condizioni, dalla legge. Non risulta chiaro, in verità, se tali condizioni fossero state o meno soddisfatte. Ma non è su questo che si vuole qui puntare l’attenzione, quanto piuttosto sul fatto che è, comunque, la socializzazione in ambito scolastico quella che viene, in sostanza, considerata imprescindibile ai fini di una corretta formazione della personalità del minore. E questo tipo di socializzazione è caratterizzato dal suo svolgersi secondo le direttive e sotto la supervisione di un’autorità che, direttamente o indirettamente, è quella dello Stato.

In sostanza, si lascia, quindi, intendere che, pur nel dichiarato rispetto dell’articolo 30 della Costituzione secondo cui è «dovere e diritto dei genitori mantenere, istruire ed educare i figli», è però preferibile che l’istruzione e l’educazione siano affidate allo Stato. E su questa stessa linea si pongono le forze politiche e gli «opinion makers» che sostengono la necessità o, quanto meno, l’opportunità che nei programmi scolastici venga inserita l’educazione «sessuo-affettiva» per supplire alle presunte carenze o distorsioni frequentemente riscontrabili - si afferma - nell’educazione che, in materia sessuo-affettiva, i minori ricevono in famiglia. Il tutto riconducibile a una visione generale secondo cui spetterebbe allo Stato curare la formazione della personalità di ogni cittadino, fin dalla più tenera età, in modo da renderla conforme a un modello ideale precostituito, funzionale al modello assunto come proprio dallo Stato nel suo complesso. Visione, questa, che ben può trovare la sua collocazione nell’ambito di quella che viene oggi da molti definita come «democrazia totalitaria», riprendendo, pur sotto varie e diverse angolature, un concetto enunciato per la prima volta, nel 1952, dallo storico israeliano Jakob Talmon nel suo libro The origins of totalitarian democracy.

Ma si tratta di una visione le cui radici, risalendo addirittura all’antichità, possiamo ritrovare nella Repubblica di Platone, in cui si immaginava uno Stato governato dai «filosofi», nel quale, tra l’altro, la famiglia tradizionale fosse abolita e i figli, nati da accoppiamenti decisi dalla sorte, fossero affidati, fin dalla più tenera età, alla pubblica autorità. Questa raffigurazione di quello che avrebbe dovuto essere, secondo l’autore, lo Stato ideale rimase, in realtà, pressoché isolata nel pensiero dell’antichità greco-romana. Essa venne, però, ripresa a partire dal XVI secolo in varie opere le più note delle quali sono l’Utopia di Thomas More e La città del Sole, di Tommaso Campanella. In quest’ultima, in particolare, si torna a predicare l’abolizione della famiglia e l’esclusiva competenza dello Stato a provvedere all’educazione dei figli nati dalle unioni sessuali decise, peraltro, non più dalla sorte ma dalle autorità. Più moderata risulta la posizione del More, il quale lascia sussistere la famiglia tradizionale salvo, però, prevedere che il numero dei figli per ogni famiglia sia fissato dall’autorità, per cui, in caso di superamento, i figli in eccedenza sono assegnati a un’altra famiglia che non ne ha avuti a sufficienza.

Una radicale avversione alla famiglia, accompagnata alla pretesa che i figli, comunque venuti al mondo, debbano essere affidati, il prima possibile, alle cure esclusive dello Stato o della «comunità», costituisce

poi - come messo bene in luce da Igor Safarevich nel suo Il socialismo come fenomeno storico mondiale, pubblicato la prima volta nel 1977 - elemento ricorrente in pressoché tutti i numerosi progetti di società qualificabili, in senso lato, come «socialisti» in quanto basati sul rifiuto di ogni forma di libera iniziativa e di proprietà individuale, comparsi a partire dal XVIII secolo. Fra essi, a titolo di esempio: Il codice della natura, ovvero l’autentico spirito delle leggi, di Morelly (probabile pseudonimo di Denis Diderot); Il vero sistema, di Léger DeschampsIl nuovo mondo industriale e societario, di François Fourier; la Congiura per l’eguaglianza, di Filippo Buonarroti. Sulla stessa linea si ritrova, poi, l’opera specificamente dedicata, da Friedrich Engels, alla Origine della famiglia, della proprietà privata e dello Stato.

Ci si potrebbe chiedere, tuttavia, a questo punto, come mai l’attuale pretesa dello Stato di estromettere, per quanto possibile, le famiglie dall’educazione dei figli, pur essendo ricollegabile, come si è visto, a originarie visioni di tipo collettivistico, si accompagni invece, oggi, a una diffusa mentalità di tipo edonistico-individualista, in buona parte avallata anche dallo stesso Stato. Può rispondersi che ciò appare come uno dei frutti della commistione, verificatasi a partire dal 1968, tra l’edonismo individualista proprio della tradizione anglo-sassone, resosi dominante in Occidente ma non più compensato dal moralismo di stampo calvinista, proprio anch’esso di quella tradizione, e l’egualitarismo delle visioni collettiviste, fatte proprie ed in parte realizzate nel marxismo, ma non più compensate, a loro volta, dalla dichiarata finalità della creazione di un ordinamento statuale in cui esse trovassero compiuta realizzazione; finalità, quella ora detta, la cui scomparsa ha lasciato, tuttavia, come residuo, l’antico e talvolta confessato convincimento di molti fra i politici e pensatori della sinistra marxista che quelli in favore dei quali doveva promuoversi e garantirsi l’eguaglianza, essendo privi di adeguata intelligenza (Engels definì una volta, in una lettera a Marx, gli operai come «una massa spaventosamente idiota»), dovessero essere guidati e diretti, fin dalla nascita, da chi ne sapeva più di loro.

Ed è proprio, quindi, quella commistione che bisognerebbe decidersi, una volta o l’altra, a spezzare.

Continua a leggereRiduci

iStock

Talvolta mi trovo di fronte a gruppi organizzati, talvolta a gruppi appartenenti a città diverse ma che tra di loro instaurano delle relazioni non tali da formare un vero e proprio movimento, ma certamente tali da rafforzare la loro appartenenza a un non ben definito «gruppo sociale» in modo che si rafforza in loro l’idea di non essere soli, ma di appartenere a una sorta di «comunità», pur non conoscendosi personalmente, pur non frequentandosi se non attraverso i social.

Se uno si mette a parlare con loro, cercando di capire qual è, e se c’è, una visione, un’idea della loro vita e del significato delle cose che fanno, tornerà a casa con un pugno di mosche in mano. La prima impressione, infatti, che si ricava dal parlare con loro è che tutto ruota intorno a qualche comportamento che consiste nel portare il coltello in tasca come arma di difesa da persone che sono sostanzialmente uguali a loro, di uso delle stesse armi da taglio, se non da sparo, per ottenere un paio di scarpe griffate o qualcosa del genere (più raramente soldi) che rappresenta il simbolo di ciò che, nella loro mente, è per loro un diritto avere e, quindi, devono procurarselo al di là di ogni norma, di ogni legge, di ogni comportamento benevolo nei confronti degli altri che possono permetterselo.

Accade spesso che alcune aggressioni verso persone che non appartengono a questi gruppi avvengano anche senza una motivazione che possa essere ricondotta alla all’appropriarsi indebitamente di beni altrui: soldi, meno spesso, capi di abbigliamento trendy (secondo loro), cappellini, giubbotti, scarpe, jeans, cinture, borselli e zainetti. Molte volte certe aggressioni, veri e propri pestaggi, accoltellamenti qualche volta letali (comunque praticamente sempre necessitanti di cure mediche, se non interventi chirurgici), ebbene tutto questo avviene senza un motivo che non sia quello di compiere la violenza per il gusto della violenza e per il fatto che, compiendo questi atti, si è qualcuno, si è una personalità, si tratteggia la propria soggettività in modo che sia riconoscibile agli altri, positiva per gli aderenti al gruppo o a altri gruppi che compiono gli stessi gesti, negativa per chi subisce questi gesti e per chi ritiene questi comportamenti immorali e illegali. Questo secondo gruppo di persone che contestano le azioni dei teppisti (raramente, se non mai, si tratta di azioni individuali) rafforzano l’identità e l’idea di questi delinquenti di essere nel giusto.

Uno potrebbe legittimamente chiedersi: «Ma qualcuno che compie un’azione senza motivazione, come questi gruppuscoli compiono le loro azioni violente senza un’apparente causa, come fanno a sentirsi rafforzati compiendo qualcosa senza alcun significato? Questa domanda ci porta fuoristrada perché, per gli appartenenti a questi gruppi, questo non costituisce un problema. Quando uno compie la violenza per la violenza è perché sente che quella violenza è la migliore espressione di sé, da una parte, e dall’altra lo rende soggetto riconoscibile all’interno della società che pure li disprezza, ma per loro questo è un segno che stanno agendo «bene»: agiscono, cioè, per un fine che è quello di esprimere sé stessi nella violenza e di assumere così un ruolo riconosciuto, sia pure negativamente, dalla società che secondo loro non ha fatto quello che avrebbe dovuto fare e, quindi, sono legittimati a compiere queste azioni come dimostrative di uno stato di disagio contro quello che, alla fine, chiamano Stato.

Rientra in questa logica anche l’attacco alle forze di polizia, in quanto rappresentanti dello Stato e perché si comporterebbero in modo discriminatorio nei loro confronti, soprattutto quando questi soggetti sono immigrati, con la pelle nera e magari con situazioni irregolari sia familiari sia che riguardano loro direttamente, magari perché hanno precedenti in giovane età. Perché attaccano la polizia? Perché ritengono di essere discriminati dalla polizia? Certo, non escludiamo a priori che qualche rappresentante delle forze dell’ordine possa avere avuto nei loro confronti comportamenti censurabili. Ma trattasi di eccezioni.

Nella norma, le forze dell’ordine non fanno che accertamenti su soggetti o conosciuti o che frequentano ambienti che possono far pensare che non tutto sia regolare per quanto li riguarda. Ma anche qui non c’è da cercare un’idea, un ideale, una qualche forma anche pur primitiva di ideologia, si tratta di una legge del branco e anche in questo caso di un branco che vive compiendo questi atti e trovando la loro identità nel fatto stesso che li compiono.

Insomma, purtroppo dietro c’è il nulla, almeno da un punto di vista ideologico, a meno che non si voglia elevare al rango di ideologia quello che abbiamo descritto.

Tornando alla domanda iniziale, dov’è che possiamo trovare un’idea che fa da propulsore a questo tipo di comportamenti? La risposta è, in un certo senso, devastante: da nessuna parte. Non è un’idea quella da cercare per spiegare questi fenomeni ma è la vita di queste persone che si svolge, che si sviluppa, che si alimenta, che degenera nella frequentazione dei social. Quello è il mondo, per loro. Quello reale è il mondo degli altri, dei loro nemici, di chi ha più di loro, di chi è diverso da loro, della polizia, dello Stato che, genericamente, non ha dato loro quello che loro era dovuto ivi compresi i cappellini, i giubbotti, le scarpe, i borselli e gli zainetti, tutti i griffati. La griffe, il marchio, l’etichetta diventano parte della loro identità, parte della loro riconoscibilità sociale, parte della loro esistenza violenta, più profondamente, della loro esistenza e del senso della loro vita. Non importa il consenso sociale, importa il consenso sui social. Non importa quella che, con termine antico, si definisce l’onorabilità, importa la riconoscibilità. Non importa il giudizio sulle loro azioni, importa la ridondanza delle loro azioni che rende le loro vite diverse dalle altre e, pur prive di contenuto, distinte da un punto di vista identitario. Di un’identità basata sul nulla, ma questo nulla, per loro, è tutto.

Allora c’è da chiedersi se non sia proprio nei confronti dei social e nei confronti di coloro che hanno macinato miliardi costruendoli, rendendoli così potenti, accessibili a chiunque, fruibili da chi non ha ancora gli strumenti e un livello di personalità tali da poter vagliare criticamente i contenuti proposti, e proprio a questi signori che dobbiamo attribuire gran parte di questa responsabilità, senza infingimenti, senza paure di essere trattati da censori morali senza averne l’autorità. Questi signori che cancellano (che bannano) contenuti leciti ma non coincidenti con le cosiddette culture dominanti (ad esempio quella definita woke), perché non cominciano a bannare i contenuti di istigazione alla violenza che sono presenti nei post di questi gruppi, di questi singoli, di alcune associazioni, nei testi dei rapper? Perché non compiono un gesto di responsabilità civile autoregolamentandosi e cominciando a occuparsi di tutta quella violenza, quel disprezzo per la figura femminile, l’incitamento all’odio sociale, dell’incitamento esplicito, ripetuto, invadente e pervadente alla violenza, all’uso delle armi da taglio, all’uso delle armi nonché l’istigazione al pestaggio di persone innocenti che non hanno fatto nulla a nessuno?

È inutile che questi personaggi proprietari e responsabili di queste piattaforme si vantino di aver dato vita a fondazioni benefiche, di aver fatto opere di mecenatismo e, nel contempo, lasciare che i giovani, gli adolescenti e i preadolescenti rischino di perdere la loro vita perché immersi in questo nulla profittevole per pochi al mondo e che danneggia vite di chi frequenta e di coloro che subiscono le violenze dei frequentatori.

Continua a leggereRiduci

I poster del Super Bowl LX esposti all'esterno del Levi's Stadium di Santa Clara in California (Ansa)

Questa notte, mentre in Italia l’orologio scorrerà oltre la mezzanotte, a Santa Clara, in California, si giocherà il Super Bowl LX, la sessantesima edizione della finale del campionato di football americano. Al Levi’s Stadium, nella Bay Area di San Francisco, si affronteranno i Seattle Seahawks e i New England Patriots, in una sfida che vale il Vince Lombardi Trophy e che riporta una contro l’altra due franchigie già protagoniste undici anni fa, nel Super Bowl XLIX.

Il Super Bowl non è soltanto l’ultima partita della stagione di Nfl. Negli Stati Uniti è un vero e proprio rito collettivo, un appuntamento che dal 2021 cade stabilmente la seconda domenica di febbraio, tanto da essere chiamato Super Bowl Sunday, una sorta di festa non ufficiale. Famiglie e amici si riuniscono davanti alla televisione, tra cibo veloce e bevande, e lo stesso accade in molti Paesi del mondo. In media, il Big Game viene seguito da oltre 120 milioni di spettatori, con numeri ancora più alti quando si considera lo spettacolo dell’intervallo.

Dal punto di vista sportivo, questa edizione propone una finale che a inizio stagione pochi avrebbero previsto. I Seattle Seahawks hanno chiuso la regular season 2025 con un record di 14 vittorie e 3 sconfitte, il migliore della loro storia, conquistando la Nfc West e il primo posto nel tabellone della conference. Nei playoff hanno travolto i San Francisco 49ers e poi superato i Los Angeles Rams, tornando al Super Bowl per la prima volta dal 2014. È la quarta partecipazione per la franchigia di Seattle, che in passato ha vinto una volta il titolo. Questa sarà la prima finale con Sam Darnold come quarterback titolare: arrivato come free agent, ha guidato un attacco tra i più produttivi della lega e una difesa che ha chiuso la stagione al primo posto per punti concessi. Dall’altra parte ci sono i New England Patriots, tornati al vertice dopo stagioni difficili. La squadra ha chiuso la regular season con lo stesso record di 14-3, seconda testa di serie della Afc, e ha ritrovato i playoff per la prima volta dal 2021. L’arrivo in panchina di Mike Vrabel ha segnato una svolta immediata, con una squadra costruita attorno alla difesa e al talento del giovane quarterback Drake Maye, protagonista di una stagione di altissimo livello. Per i Patriots si tratta della dodicesima partecipazione al Super Bowl, la prima senza Tom Brady e Bill Belichick dal lontano 1997. Hanno già vinto sei volte e, in caso di successo, diventerebbero la franchigia più titolata di sempre. Come noto, la partita si giocherà al Levi’s Stadium, un impianto da circa 68.500 posti che ospita il Super Bowl per la seconda volta dopo l’edizione del 2016. La Nfl ha scelto direttamente la sede, secondo la procedura introdotta negli ultimi anni, e ha ufficializzato Santa Clara già nel maggio 2023. Per il pubblico italiano, il calcio d’inizio è previsto intorno alle 00.30 e sarà possibile vederlo in chiaro su Italia 1 e in streaming su Mediaset Infinity, oltre che su Dazn per gli abbonati.

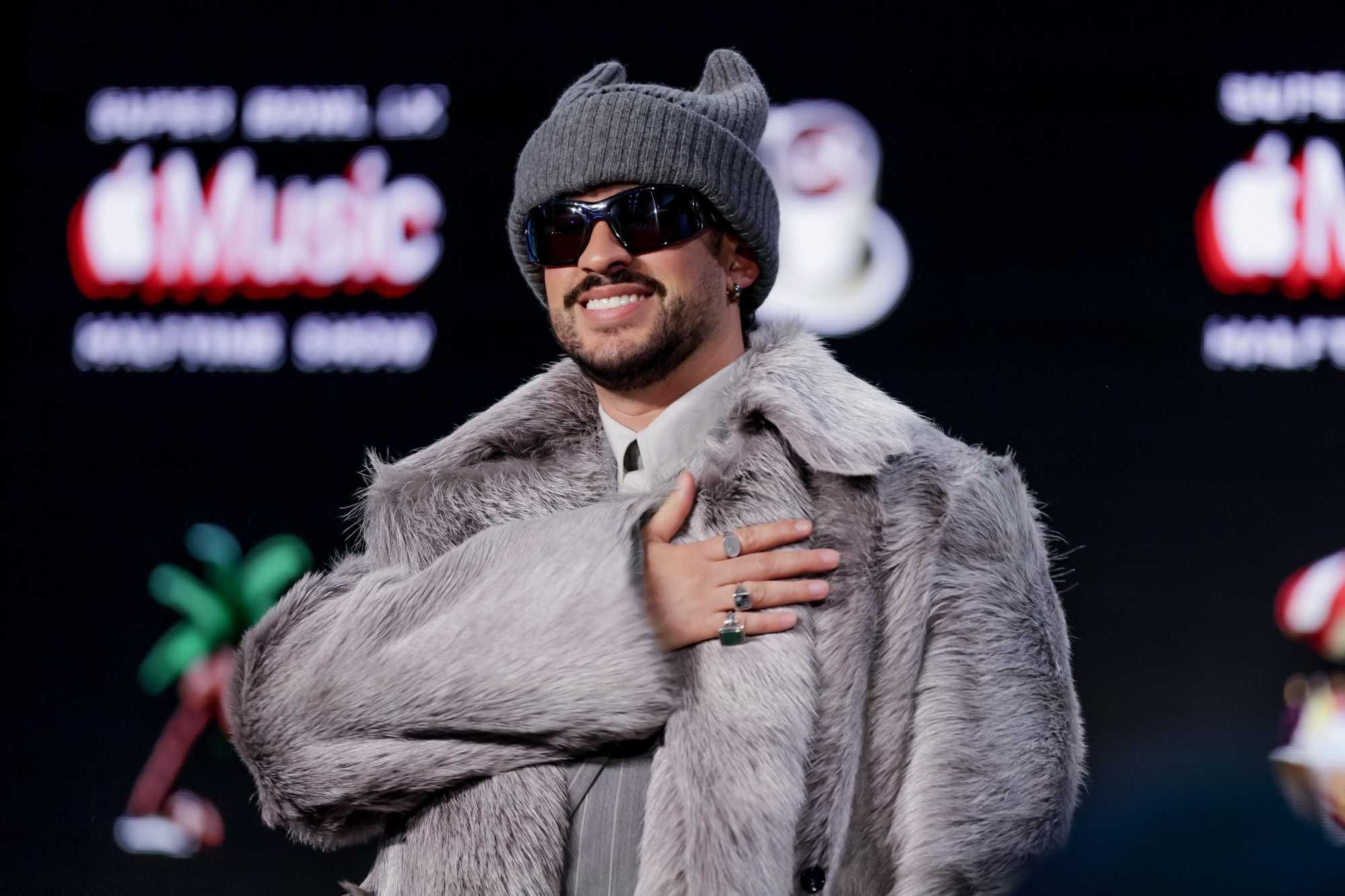

Ma il Super Bowl è anche, e forse soprattutto, uno spettacolo che va oltre il campo. Prima della partita è prevista una cerimonia di apertura dedicata agli Mvp delle passate edizioni, con l’esibizione dei Green Day, band originaria proprio della Bay Area. L’inno nazionale sarà affidato a Charlie Puth, affiancato dall’interprete della lingua dei segni americana, mentre Brandi Carlile canterà America the Beautiful e Coco Jones interpreterà Lift Every Voice and Sing, nell’ambito delle celebrazioni per il 250° anniversario degli Stati Uniti. Il momento più atteso resterà però l’halftime show. La Nfl ha annunciato ufficialmente che il protagonista sarà Bad Bunny, tre volte vincitore dei Grammy Award. Per l’artista portoricano sarà un’esibizione dal valore simbolico oltre che musicale, come lui stesso ha spiegato: «Quello che provo va oltre me stesso… è per il mio popolo, la mia cultura e la nostra storia». Lo show, come da tradizione, durerà poco più di dieci minuti e proporrà un medley dei suoi brani più noti, inserendosi in una storia che negli ultimi trent’anni ha trasformato l’intervallo del Super Bowl in un evento dentro l’evento. Dal 1993, quando fu Michael Jackson a cambiare per sempre il volto di questo spazio televisivo, sul palco si sono alternati alcuni dei più grandi nomi della musica internazionale, da Prince a Beyoncé, da Lady Gaga a Rihanna.

Oggi lo spettacolo dell’intervallo viene seguito da centinaia di milioni di persone in tutto il mondo, spesso anche da chi non è un appassionato di football. È uno dei motivi per cui il Super Bowl è diventato un appuntamento che mescola sport, intrattenimento e cultura pop, capace di attirare l’attenzione ben oltre i confini degli Stati Uniti, a conferma che il Super Bowl, sessant’anni dopo la sua nascita, resta uno degli eventi mediatici più potenti del mondo. La previsione, per quest'anno, è che saranno circa 130 milioni tra appassionati e spettatori occasionali a sintonizzarsi sull'evento.

Star, spot da capogiro e AI: il business milionario del Big Game

Bad Bunny al Moscone Convention Center di San Francisco (Ansa)

Se sul campo il Super Bowl assegna un trofeo, fuori dal campo mette in moto una macchina economica che non ha paragoni nello sport americano e probabilmente globale. L’edizione di quest'anno non fa eccezione e anzi conferma una tendenza ormai consolidata: il Big Game è diventato uno degli eventi più costosi, ambiti e redditizi dell’intero calendario sportivo mondiale.

Il primo indicatore è il prezzo dei biglietti. Secondo quanto riportato da Usa Today, per assistere alla finale tra Seattle Seahawks e New England Patriots il costo minimo parte da 6.652 dollari, oltre mille in più rispetto all’edizione precedente. Per i posti più esclusivi, soprattutto nei pacchetti Vip, si arriva fino a 90.000 dollari. Le stime parlano di un costo medio che oscilla tra i 5.000 e i 10.000 dollari, a seconda della posizione nello stadio, con il mercato secondario che tende a spingere ancora più in alto le cifre, sfruttando una domanda che resta altissima nonostante i prezzi proibitivi per la maggior parte dei tifosi. Non si tratta solo di vedere una partita. I pacchetti ufficiali includono ospitalità premium, eventi esclusivi e accesso alle feste pre-partita organizzate nel campus del Super Bowl. Attorno allo stadio, le misure di sicurezza e l’organizzazione logistica sono imponenti, a conferma di quanto l’evento sia diventato una vetrina globale non solo sportiva ma anche turistica e commerciale per la città che lo ospita.

Se i biglietti raccontano una parte del business, l’altra, ancora più rilevante, è quella legata alla pubblicità. Il Super Bowl è da anni lo spazio televisivo più ambito per i brand, e l’edizione 2026 segna nuovi record. Per uno spot di 30 secondi si arriva a sfiorare i 10 milioni di dollari, con un costo medio intorno agli 8 milioni, secondo quanto dichiarato da NBCUniversal, il gruppo che detiene i diritti di trasmissione. Al cambio attuale, significa superare abbondantemente i 9 milioni di euro per mezzo minuto di visibilità.

Queste cifre si spiegano con l’audience. Il Super Bowl dello scorso anno è stato l’evento televisivo più visto nella storia degli Stati Uniti, con 128 milioni di spettatori. Per il 2026 le previsioni parlano di circa 130 milioni di persone davanti allo schermo. Numeri che trasformano ogni spazio pubblicitario in una vetrina unica, capace di raggiungere in una sola sera un pubblico che nessun altro programma può garantire. Non sorprende quindi che gli inserzionisti preparino campagne pensate appositamente per questa occasione, spesso con mesi di anticipo. Quest’anno una parte consistente degli spot arriva dal settore tecnologico, farmaceutico e del benessere, con una novità che segna un ulteriore cambio di passo: durante la finale andrà in onda uno spot di 30 secondi realizzato interamente con l’intelligenza artificiale, per promuovere una marca di vodka. Il video ha per protagonisti due robot che ballano, con una coreografia nata da un concorso online e poi rielaborata dall’AI. Non è la prima volta che l’intelligenza artificiale entra nel mondo del Super Bowl, ma questa edizione sembra segnare un salto di livello, tanto che anche OpenAI sarà presente tra gli inserzionisti, mentre Anthropic ha scelto una strada più tradizionale per il proprio debutto televisivo. Accanto alla tecnologia, non mancano le star del cinema e della televisione, da Emma Stone a Chris Hemsworth, a conferma di quanto il Super Bowl resti un palcoscenico privilegiato per i grandi volti dello spettacolo. Allo stesso tempo, l’avanzata dell’AI e delle produzioni più snelle lascia intravedere un futuro in cui alcuni brand potrebbero rinunciare ai cachet milionari delle celebrità per puntare su soluzioni più rapide e meno costose, senza rinunciare all’impatto mediatico.

Il valore commerciale del Super Bowl non si esaurisce negli spot. L’evento è anche il momento scelto dalle grandi major per lanciare in anteprima i trailer dei film più attesi della stagione, trasformando l’intervallo pubblicitario in una sorta di vetrina dell’industria dell’intrattenimento. È un altro segnale di come il Big Game sia diventato un crocevia tra sport, marketing e cultura pop. In questo contesto, la partita tra Patriots e Seahawks è solo una parte del racconto. Intorno al campo ruota un giro d’affari che comprende diritti televisivi, sponsorizzazioni, turismo, merchandising e pubblicità, con cifre che crescono di anno in anno. Il Super Bowl è ormai molto più di una finale: è un evento che misura la sua importanza non solo nei punti segnati sul tabellone, ma anche nei milioni di dollari che riesce a muovere in una sola notte.

Continua a leggereRiduci

Il luogo del ritrovamento del corpo di Zoe Trinchero (nel riquadro) a Nizza Monferrato (Ansa)

Un peso, anzi due, sulla coscienza di chi ancora banalizza la gravità degli eventi, ormai quotidiani, a cui siamo tutti, più o meno direttamente, chiamati ad assistere. Da un lato la violenza efferata che cresce tra i giovanissimi in un circuito che, per età degli attori e gravità dei fatti, risulta evidentemente fuori controllo e che invece, da una buona parte della «sinistra che fa cultura», viene ancora espressamente negato. Dall’altro, ancora più urgente, l’allarme dei cittadini, ormai alle stelle, nei confronti dell’immigrazione incontrollata, che invade (per numero di atti violenti messi a segno) gli spazi urbani in cui si svolge la vita quotidiana. Una tensione sociale diffusa, ideologicamente derubricata a «razzismo», dovuta invece alle tante, troppe volte in cui il sistema tollera ciò che non dovrebbe, in cui giustizia non viene fatta, in cui i cittadini che chiedono più regole e interventi decisi, finiscono nel tritacarne del buonismo, etichettati come «di destra».

Zoe, fino alla mezzanotte di venerdì, era una giovane «vivace e piena di energia», tanto che «quando arrivava lei anche una brutta serata si trasformava per tutti», hanno raccontato gli amici. Lavorava al bar della stazione di Nizza Monferrato (9.000 abitanti in provincia di Asti), un punto di ritrovo noto per gli aperitivi e molto frequentato, nonostante la zona non centrale. Era stata assunta qualche mese fa e piaceva a tutti: ai proprietari del locale, che la descrivono come «una ragazza dolcissima, capace e sveglia», e ai clienti che l’hanno ricordata come «sempre gentile e sorridente». Una ragazza forte, con una grande voglia di essere indipendente e il sogno di diventare psicologa.

Secondo le ricostruzioni, finito il turno di servizio, intorno alle 21, Zoe si è portata verso il centro del paese per incontrare il suo gruppo di amici in una birreria e da lì, tutti insieme, i ragazzi, si sono spostati a casa di uno di loro, per cenare. Durante la serata li avrebbe raggiunti Alex Giuseppe Manna, che Zoe conosceva e che da un po’ di tempo, a quanto pare, era diventato con lei più insistente. Niente era accaduto però, fino a quella sera, che avesse allarmato la giovane o chi la conosceva. Zoe e Alex sono usciti insieme a fare due passi, probabilmente per parlare da soli. Intorno a mezzanotte, però, ancora non erano tornati e gli amici di Zoe, preoccupati, sono scesi per strada a cercarla.

E qui entra in scena il tunisino che ha rischiato di essere linciato. Gli amici di Zoe, come hanno raccontato, temevano che la giovane lo avesse incontrato e che fosse accaduto qualcosa. Il soggetto, infatti, è conosciuto come uno per nulla raccomandabile e anche a causa di «gravi problemi psichiatrici» e «disturbi del comportamento», eppure mai è stato raggiunto da provvedimenti capaci di metterlo in sicurezza. Anzi, secondo i racconti, se ne va in giro per il paese indisturbato nonostante le tangibili esternalità del suo stato psichico, lasciando dietro di sé quel senso di angoscia che alberga in chi non può camminare liberamente per la sua città, senza temere di imbattersi in un potenziale (e già noto) pericolo. A tal punto il tunisino è considerato minaccioso, che gli amici di Zoe da tempo andavano a prenderla a fine turno «facendole da scorta per il timore che potesse incontrarlo».

Approfittando di questo, Alex Manna ha tentato di scaricare proprio su di lui le sue colpe: secondo le ricostruzioni, dopo aver picchiato e strangolato la giovane e dopo essersi cambiato i vestiti per allontanare i sospetti da sé, avrebbe chiamato gli amici di Zoe, sostenendo di essere stato aggredito insieme a lei dal tunisino e di non essere riuscito a proteggere la ragazza.

Nel frattempo un passante, che aveva notato un corpo nel canale nel sottostrada e stava contattando le forze dell’ordine per dare l’allarme, ha incrociato proprio gli amici di Zoe che la stavano cercando e che si sono subito accorti che quel corpo esanime, finito in basso nel torrente tra le case, era della loro amica. Qualcuno per tentare di salvarla è sceso in acqua, ma Zoe era già morta: il suo viso era ricoperto di lividi e segni di strangolamento sul collo.

A quel punto, sconvolti dal dolore, gli amici insieme a altre decine di persone del paese si sono radunati sotto l’abitazione del tunisino, pronti a linciarlo. Il livello di tensione è salito a tal punto che è stato necessario l’intervento dei carabinieri per evitare che l’uomo venisse assalito. Poco dopo, in caserma, sotto interrogatorio, Alex - ora in carcere ad Alessandria - ha confessato l’omicidio, raccontando almeno una parte dei fatti. Il ragazzo ha sostenuto di aver sferrato, da ex boxeur esperto, uno o due pugni sul viso di Zoe che si sarebbe accasciata e di aver poi buttato, preso dal panico, il suo esile corpo oltre il parapetto.

Ora gli inquirenti stanno valutandola corretta qualificazione del reato, ovvero se incolpare l’assassino di omicidio oppure di femminicidio.

Continua a leggereRiduci